Сумма цифр

Су́мма цифр в математике — сумма всех цифр натурального числа в конкретной системе счисления. Например, сумма цифр десятичного числа равна .

Определение

правитьПусть — натуральное число. Определим сумму цифр для основания следующим образом:

где — это количество цифр в этом числе в системе счисления с основанием , и

- — значение каждой цифры числа.

Например, в системе счисления с основанием 10, сумма цифр числа 84001 равна .

Для любых двух оснований и для достаточно больших натуральных чисел ,

- .[1]

Использование

правитьИдея десятичной суммы цифр близко связана, но не совпадает с таким понятием, как цифровой корень — результат повторного применения суммы цифр до того, как оставшееся значение будет числом, состоящим из одной цифры. Цифровой корень всегда является числом от 1 до 9, в то время как сумма цифр может принимать любое значение. Сумма цифр и цифровой корень используются для признаков делимости: натуральное число делится на 3 или 9 тогда и только тогда, когда его сумма цифр (или цифровой корень) делится на 3 или 9 соответственно.

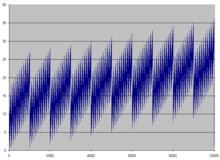

Сумма цифр также часто используется в алгоритмах с контрольной суммой, чтобы проверить работу арифметических операций на ранних компьютерах. Ранее, в эпоху ручных расчётов, Фрэнсис Исидор Эджуорт предложил использовать суммы 50 цифр, взятых из таблиц логарифмов в качестве генерации случайных чисел; если предположить, что каждая цифра случайна, то по центральной предельной теореме эти суммы цифр будут распределены случайно схоже с нормальным распределением.

Сумма цифр числа в двоичной системе счисления известна как вес Хемминга; алгоритмы для произведения этой операции были изучены и включены как встроенные функции в некоторые архитектуры и языки программирования. Эти операции используются в компьютерных программах, в том числе в криптографии, теории кодирования и компьютерных шахматах.

Числа харшад определены как числа, делящиеся на сумму своих цифр, а числа Смита определены равенством между суммой их цифр и суммой цифр их факторизации.

См. также

правитьПримечания

править- ↑ Bush, L. E. (1940), "An asymptotic formula for the average sum of the digits of integers", American Mathematical Monthly, 47 (3), Mathematical Association of America: 154—156, doi:10.2307/2304217, JSTOR 2304217.